Generative AI is reality and it's better to be its co-creator then its consumer.

Learning by doing & experimenting & creating critical stance.

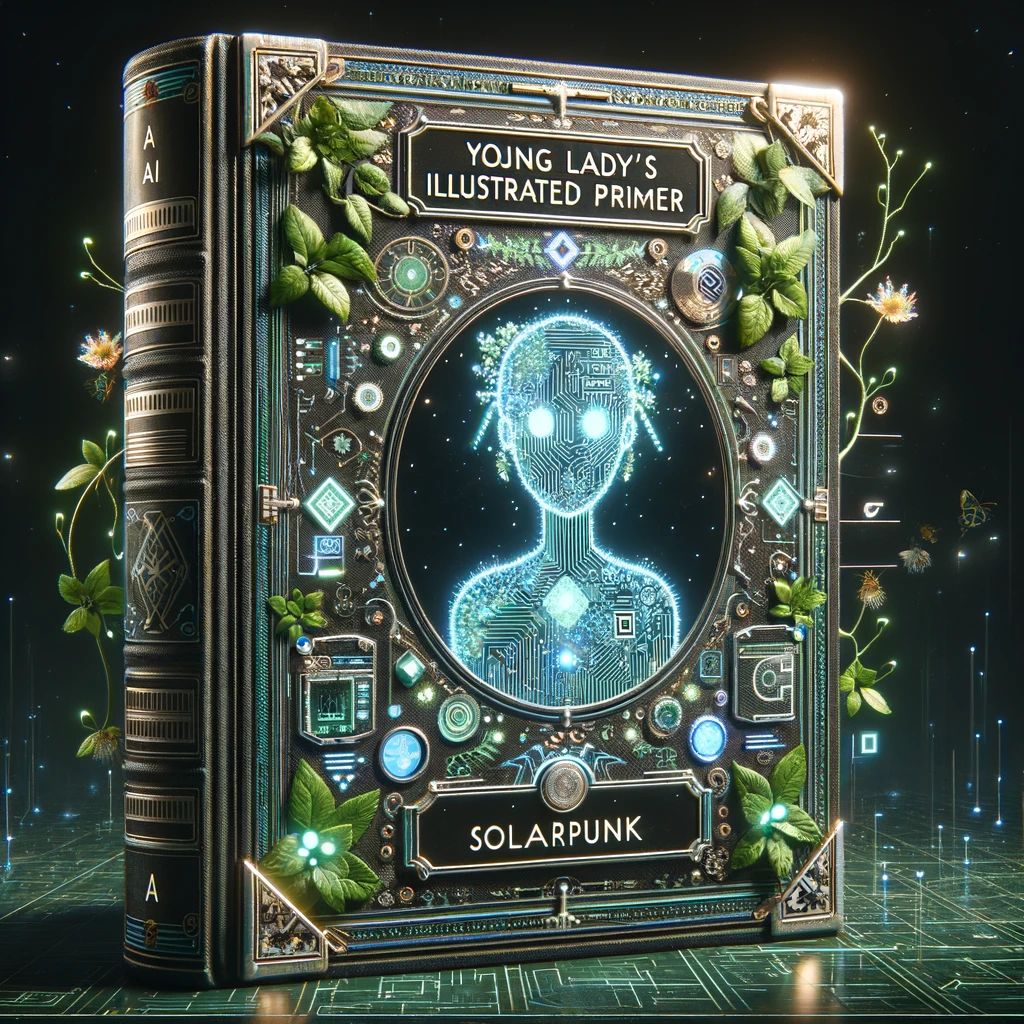

Personalized AI tutors are important components of vaste majority of future educational systems.

Property "avatarized" is the property 23 on the roadmap to an ideal Bildungsinstrument I've been working on since some times.

Artificial Intelligence in Education (AIED): Education about AI & Education with AI

generative artificial intelligence (notably large language models, text-to-speech / voice cloning, talking head generation)

multi-modal & collective avatars

open-source tools (text-webui-..., comfy ui), programming languages (python, mojo), models (Stable Diffusion, Mistral) & concrete methods (LORA, Direct Preferenc Optimization)

tweaking knobs & parameters

& maybe little bit of "prompt engineering"

dysinformation

deep-fakes of living persons

corporate products

entertainment (e.g. humor / horror / porn / cognitive spam)

so-called discriminative AI (e.g. speech/face/object recognition etc.)

I-avatarizaion

Anything else?

.png)

"training" when the AI is learning from the data we provide it

"inferencing" when the AI is using its current "knowledge" to solve new problems (e.g. problems which maybe weren't in the training data at all)